Sau khi đã tìm hiểu qua về các khái niệm như Types of Caching, Cache Invalidation…Chúng ta sẽ tìm hiểu thêm các vấn đề còn lại của Cache.

Các chiến lược đọc Cache(Read Strategies)

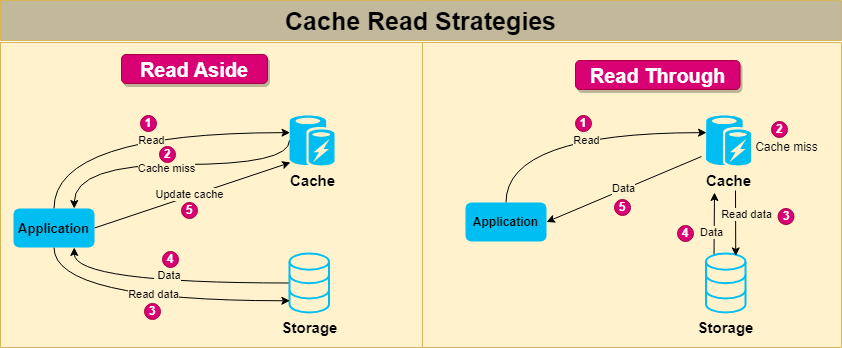

1.Read through cache

Chiến lược read-through cache là một cơ chế lưu trữ cache, trong đó chính cache chịu trách nhiệm lấy dữ liệu từ kho dữ liệu cơ bản khi xảy ra tình trạng thiếu cache (cache miss). Trong chiến lược này, ứng dụng yêu cầu dữ liệu từ cache thay vì từ kho dữ liệu trực tiếp. Nếu dữ liệu được yêu cầu không được tìm thấy trong cache (cache miss), cache sẽ lấy dữ liệu từ kho dữ liệu, cập nhật cache với dữ liệu đã được lấy và trả dữ liệu lại cho ứng dụng.

Cách tiếp cận này giúp duy trì tính nhất quán giữa cache và kho dữ liệu, vì cache luôn chịu trách nhiệm lấy và cập nhật dữ liệu. Nó cũng đơn giản hóa mã nguồn của ứng dụng, vì ứng dụng không cần phải xử lý tình trạng thiếu cache và logic lấy dữ liệu. Chiến lược cache đọc qua có thể cải thiện hiệu suất đáng kể trong các tình huống mà việc lấy dữ liệu từ kho dữ liệu tốn kém và tình trạng thiếu cache tương đối ít xảy ra.

2.Read aside cache

Chiến lược read-aside cache, còn được gọi là cache-aside hoặc lazy-loading, là một cơ chế lưu trữ cache, trong đó ứng dụng chịu trách nhiệm lấy dữ liệu từ kho dữ liệu cơ bản khi xảy ra tình trạng thiếu cache (cache miss). Trong chiến lược này, ứng dụng đầu tiên kiểm tra cache để tìm dữ liệu được yêu cầu. Nếu dữ liệu được tìm thấy trong cache (cache hit), ứng dụng sẽ sử dụng dữ liệu đã lưu trong cache. Tuy nhiên, nếu dữ liệu không có trong cache (cache miss), ứng dụng sẽ lấy dữ liệu từ kho dữ liệu, cập nhật cache với dữ liệu đã được lấy và sau đó sử dụng dữ liệu.

Chiến lược cache đọc bên cạnh cung cấp kiểm soát tốt hơn đối với quá trình lưu trữ cache, vì ứng dụng có thể quyết định khi nào và như thế nào để cập nhật cache. Tuy nhiên, nó cũng làm tăng độ phức tạp của mã nguồn ứng dụng, vì ứng dụng phải xử lý tình trạng thiếu cache và logic lấy dữ liệu. Cách tiếp cận này có thể có lợi trong các tình huống mà tình trạng thiếu cache tương đối ít xảy ra và ứng dụng muốn tối ưu hóa việc sử dụng cache dựa trên các mẫu truy cập dữ liệu cụ thể.

Tính Nhất Quán và Mô Hình Đồng Bộ của Cache(Cache Coherence and Consistency Models)

Các mô hình nhất quán và đồng bộ cache (cache coherence and consistency models) là những khái niệm thiết yếu trong ngữ cảnh lưu trữ cache, đặc biệt là trong các hệ thống phân tán hoặc bộ xử lý đa lõi. Những mô hình này đảm bảo rằng dữ liệu luôn chính xác và được cập nhật trên nhiều cache hoặc đơn vị xử lý khác nhau.

1.Cache Coherence

Tính đồng bộ cache (cache coherence) là một đặc tính của các bộ xử lý đa lõi hoặc hệ thống phân tán, đảm bảo rằng tất cả các bộ xử lý hoặc nút đều thấy cùng một phiên bản của dữ liệu chia sẻ. Trong một hệ thống có nhiều cache, mỗi cache có thể lưu trữ một bản sao dữ liệu chia sẻ. Khi một cache thay đổi bản sao của nó, rất quan trọng để tất cả các cache khác nhận biết được sự thay đổi này nhằm duy trì một cái nhìn nhất quán về dữ liệu.

Để đạt được tính đồng bộ cache, có thể sử dụng nhiều giao thức và kỹ thuật khác nhau, chẳng hạn như:

- Ghi không hợp lệ (Write-invalidate): Khi một cache ghi vào bản sao dữ liệu chia sẻ của nó, nó sẽ phát đi một thông điệp đến các cache khác, làm không hợp lệ các bản sao của chúng. Khi một cache khác cần dữ liệu đã được cập nhật, nó sẽ lấy dữ liệu mới từ bộ nhớ hoặc từ cache đã thực hiện thay đổi.

- Cập nhật ghi (Write-update hoặc write-broadcast): Khi một cache ghi vào bản sao dữ liệu chia sẻ của nó, nó sẽ phát đi dữ liệu đã được cập nhật đến tất cả các cache khác, để chúng cập nhật bản sao của mình tương ứng.

2.Cache Consistency Models

Các mô hình nhất quán cache (cache consistency models) định nghĩa các quy tắc và cam kết về cách dữ liệu được cập nhật và truy cập trong một hệ thống phân tán có nhiều cache. Các mô hình nhất quán khác nhau cung cấp các mức độ nghiêm ngặt khác nhau, cân bằng giữa hiệu suất và nhu cầu về độ chính xác của dữ liệu.

- Nhất quán nghiêm ngặt (Strict Consistency): Trong mô hình này, bất kỳ lần ghi nào vào một mục dữ liệu đều ngay lập tức có thể nhìn thấy bởi tất cả các cache. Mô hình này cung cấp mức độ nhất quán cao nhất, nhưng khó đạt được trong thực tế, vì có thể yêu cầu nhiều tài nguyên đồng bộ hóa và ảnh hưởng tiêu cực đến hiệu suất.

- Nhất quán tuần tự (Sequential Consistency): Trong mô hình này, tất cả các thao tác trên các mục dữ liệu dường như xảy ra theo một thứ tự tuần tự cụ thể trên tất cả các cache. Mô hình này cho phép hiệu suất tốt hơn so với nhất quán nghiêm ngặt, nhưng vẫn yêu cầu nhiều tài nguyên đồng bộ hóa và có thể không thực tế trong nhiều hệ thống phân tán.

- Nhất quán nguyên nhân (Causal Consistency): Trong mô hình này, các thao tác có liên quan nguyên nhân (tức là một thao tác phụ thuộc vào kết quả của thao tác khác) được đảm bảo xuất hiện theo thứ tự trên tất cả các cache. Các thao tác không có liên quan nguyên nhân có thể xảy ra theo bất kỳ thứ tự nào. Mô hình này cung cấp hiệu suất tốt hơn so với nhất quán tuần tự, đồng thời vẫn đảm bảo mức độ chính xác dữ liệu hợp lý.

- Nhất quán cuối cùng (Eventual Consistency): Trong mô hình này, tất cả các cập nhật đối với một mục dữ liệu cuối cùng sẽ được truyền đến tất cả các cache, nhưng không có đảm bảo về thứ tự hoặc thời gian của các cập nhật. Mô hình này cung cấp hiệu suất tốt nhất trong số các mô hình nhất quán nhưng có cam kết nhất quán yếu nhất. Nhất quán cuối cùng thường được sử dụng trong các hệ thống phân tán, nơi hiệu suất và khả năng mở rộng được ưu tiên hơn độ chính xác dữ liệu nghiêm ngặt.

Hiểu rõ về tính đồng bộ cache và các mô hình nhất quán là rất quan trọng khi thiết kế các chiến lược lưu trữ cache cho các hệ thống phân tán hoặc bộ xử lý đa lõi. Bằng cách chọn mô hình phù hợp cho hệ thống của bạn, bạn có thể tìm được sự cân bằng giữa hiệu suất và độ chính xác dữ liệu để đáp ứng các yêu cầu cụ thể của mình.

Các Thách Thức Trong việc Caching

Các vấn đề liên quan đến bộ nhớ đệm(cache) là một tập hợp những thách thức phát sinh từ khi triển khai đến khi quản lý hệ thống bộ nhớ đệm trong các ứng dụng phần mềm. Dưới đây là những vấn đề chính liên quan đến bộ nhớ đệm và cách khắc phục có thể:

1. Thundering Herd

Vấn đề thundering herd xảy ra khi một phần dữ liệu phổ biến hết hạn trong bộ nhớ đệm, dẫn đến sự gia tăng đột ngột các yêu cầu đến máy chủ gốc để lấy dữ liệu bị thiếu. Điều này có thể gây tải quá mức cho máy chủ gốc và làm giảm hiệu suất. Các giải pháp cho vấn đề này bao gồm sử dụng thời gian hết hạn so le, triển khai khóa bộ nhớ đệm, hoặc sử dụng cập nhật nền để làm mới bộ nhớ đệm trước khi dữ liệu hết hạn.

2.Cache Penetration

Cache penetration đề cập đến tình huống khi các yêu cầu dữ liệu bỏ qua bộ nhớ đệm và truy cập trực tiếp vào máy chủ gốc, làm giảm lợi ích của việc lưu trữ đệm. Điều này thường xảy ra khi có yêu cầu về dữ liệu không tồn tại hoặc ít được truy cập. Để giảm thiểu cache penetration, có thể sử dụng negative caching (lưu trữ đệm các phản hồi âm) hoặc sử dụng bộ lọc bloom để kiểm tra sự tồn tại của dữ liệu trước khi truy vấn bộ nhớ đệm.

3.Big Key

Big key là một phần dữ liệu lớn chiếm một phần đáng kể dung lượng của bộ nhớ đệm. Việc lưu trữ big key có thể dẫn đến việc đẩy các dữ liệu khác ra khỏi bộ nhớ đệm, làm giảm hiệu quả tổng thể của hệ thống. Các giải pháp xử lý big key bao gồm nén dữ liệu trước khi lưu vào bộ nhớ đệm, chia nhỏ dữ liệu thành các phần nhỏ hơn, hoặc sử dụng chiến lược lưu trữ đệm riêng được thiết kế cho các đối tượng lớn.

4.Hot Key

Hot key là một phần dữ liệu được truy cập thường xuyên, gây ra xung đột và vấn đề về hiệu suất trong hệ thống bộ nhớ đệm. Hot key có thể dẫn đến cache thrashing và phân phối tải không cân bằng. Các giải pháp xử lý hot key bao gồm sử dụng consistent hashing để phân phối tải đồng đều hơn, sao chép hot key trên nhiều node bộ nhớ đệm, hoặc triển khai chiến lược cân bằng tải để phân phối yêu cầu trên nhiều bản sao của hot key.

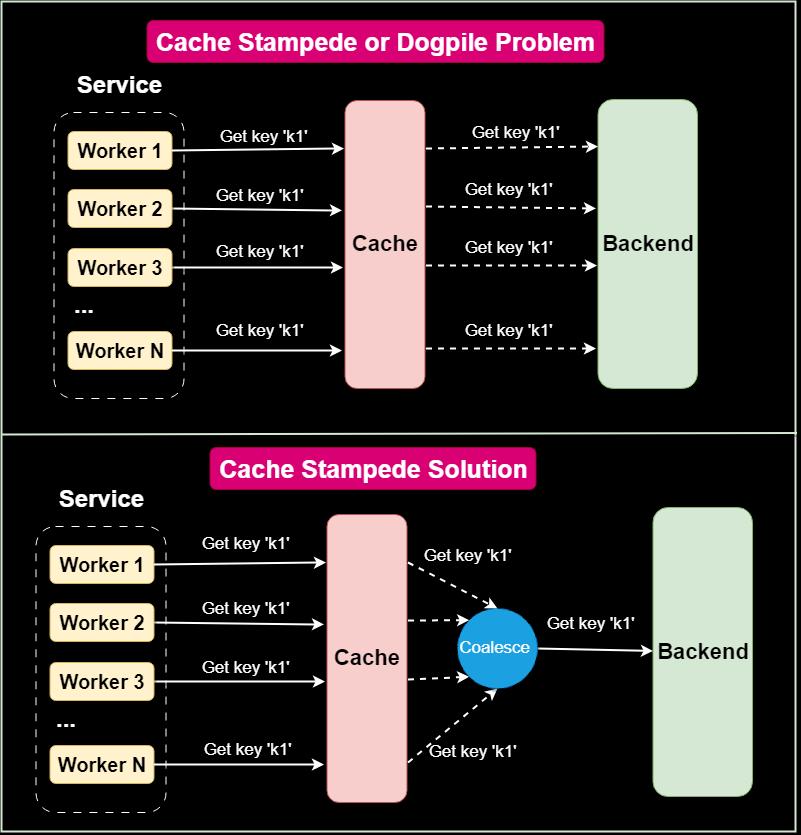

5.Cache Stampede (hay Dogpile)

Cache stampede xảy ra khi nhiều yêu cầu cho cùng một dữ liệu được thực hiện đồng thời, gây tải quá mức cho bộ nhớ đệm và máy chủ gốc. Cache stampede có thể được giải quyết bằng các kỹ thuật như request coalescing (kết hợp nhiều yêu cầu cho cùng một dữ liệu thành một yêu cầu duy nhất) hoặc triển khai read-through cache, trong đó bộ nhớ đệm tự lấy dữ liệu bị thiếu từ máy chủ gốc.

6. Cache Stampede (or Dogpile)

Cache pollution xảy ra khi dữ liệu ít được truy cập thay thế dữ liệu thường xuyên được truy cập trong bộ nhớ đệm, dẫn đến giảm tỷ lệ cache hit. Để giảm thiểu cache pollution, có thể áp dụng các chính sách loại bỏ như LRU (Least Recently Used – Ít được sử dụng gần đây nhất) hoặc LFU (Least Frequently Used – Ít được sử dụng thường xuyên nhất), các chính sách này ưu tiên giữ lại dữ liệu thường xuyên được truy cập trong bộ nhớ đệm.

7.Cache Drift

Cache drift đề cập đến sự không nhất quán giữa dữ liệu được lưu trong bộ nhớ đệm và dữ liệu trên máy chủ gốc, thường do cập nhật hoặc thay đổi trong dữ liệu. Để xử lý cache drift, cần triển khai các chiến lược vô hiệu hóa bộ nhớ đệm phù hợp để đảm bảo rằng bộ nhớ đệm được cập nhật hoặc vô hiệu hóa khi dữ liệu trên máy chủ gốc thay đổi.

Bằng cách hiểu và giải quyết các vấn đề liên quan đến bộ nhớ đệm này, chúng ta có thể cải thiện hiệu quả, hiệu suất và độ tin cậy của hệ thống bộ nhớ đệm. Điều này, từ đó, có thể nâng cao hiệu suất tổng thể và trải nghiệm người dùng của các ứng dụng.

Các Chỉ Số Hiệu Suất của Cache

Khi triển khai bộ đệm(cache), điều quan trọng là phải đo hiệu suất của bộ đệm để đảm bảo rằng bộ đệm có hiệu quả trong việc giảm độ trễ và cải thiện hiệu suất hệ thống. Dưới đây là một số số liệu hiệu suất bộ đệm phổ biến nhất:

Hit rate

Hit rate là tỷ lệ phần trăm các yêu cầu được phục vụ bởi bộ nhớ đệm mà không cần truy cập nguồn gốc ban đầu. Tỷ lệ trúng cao cho thấy bộ nhớ đệm hiệu quả trong việc giảm số lượng yêu cầu đến nguồn gốc ban đầu, trong khi tỷ lệ trúng thấp cho thấy bộ nhớ đệm có thể không mang lại lợi ích hiệu suất đáng kể.

Miss rate

Miss rate là tỷ lệ phần trăm các yêu cầu không được phục vụ bởi bộ nhớ đệm và cần phải được lấy từ nguồn gốc ban đầu. Tỷ lệ hụt cao cho thấy bộ nhớ đệm có thể không lưu trữ dữ liệu đúng hoặc kích thước bộ nhớ đệm có thể không đủ lớn để lưu trữ tất cả dữ liệu thường xuyên được truy cập.

Cache size

Cache size là lượng bộ nhớ hoặc lưu trữ được phân bổ cho bộ nhớ đệm. Kích thước bộ nhớ đệm có thể ảnh hưởng đến hit rate và miss rate của bộ nhớ đệm. Kích thước bộ nhớ đệm lớn hơn có thể dẫn đến hit rate cao hơn, nhưng cũng có thể làm tăng chi phí và độ phức tạp của giải pháp bộ nhớ đệm.

Cache latency

Cache latency là thời gian cần thiết để truy cập dữ liệu từ bộ nhớ đệm. Độ trễ bộ nhớ đệm thấp hơn cho thấy bộ nhớ đệm nhanh hơn và hiệu quả hơn trong việc giảm độ trễ và cải thiện hiệu suất hệ thống. Độ trễ bộ nhớ đệm có thể bị ảnh hưởng bởi công nghệ bộ nhớ đệm được sử dụng, kích thước bộ nhớ đệm, và các chính sách thay thế và vô hiệu hóa bộ nhớ đệm.

Vậy là chúng ta đã đi qua các khái niệm cơ bản của bộ nhớ đệm(Cache), hi vọng qua loạt bài này mọi người đã hiểu hơn về cache.Chúc mọi người làm việc vui vẻ.

Để lại một bình luận